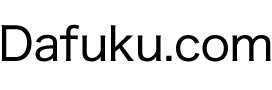

Webマスターツールに【クロールエラー】という項目があります。GoogleのボットがURLに辿りつけないと、エラーとしてカウントされます。このエラーは、なるべるなくしたほうが良いですね。

クロール出来ていないURLを見ると、そもそも記事ページURLで無かったり、プラグインによって自動生成されたページだったりします。

なので記事ページ以外のURLは辿らないようにGoogleに伝えなければなりません。そこで必要になるのがrobots.txtです。

WordPressで作成されたサイトはrobots.txtがデフォルトで生成されます。しかし、このファイルだとGoogleボットが余計なページをクロールしてしまうので不十分です。

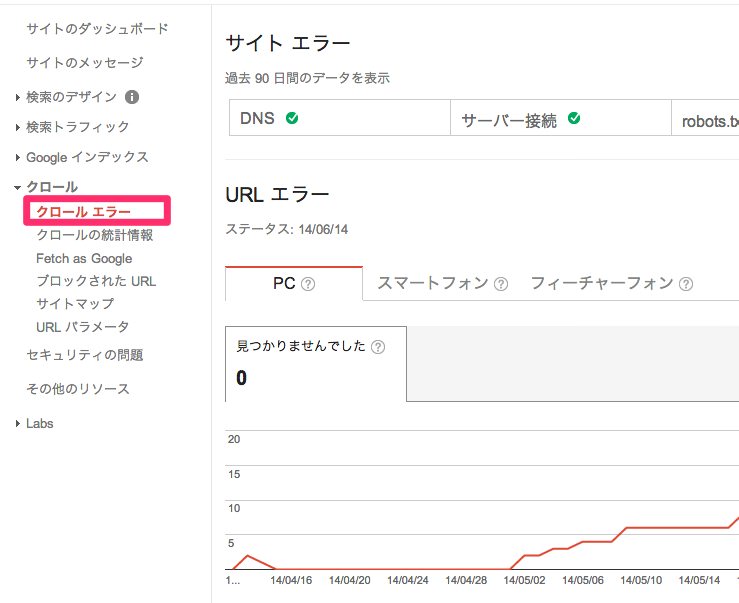

WordpresのプラグインKB Robots.txtを使ってrobots.txtを編集する必要があります。

KB Robots.txtをインストールし有効化させるとメニューに項目が追加されます。

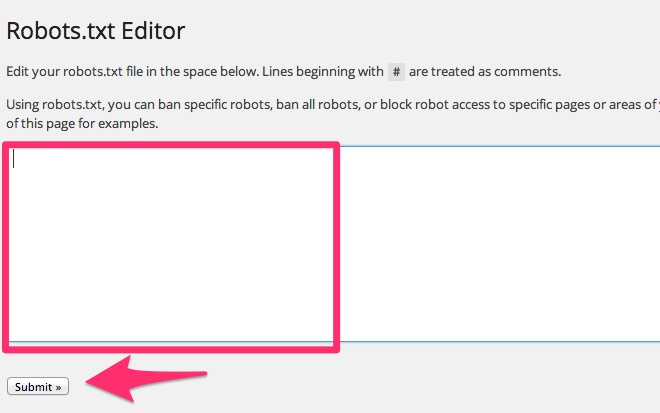

四角い枠に辿らせたくないURLやページを入力

(例)

User-agent: *

Allow: /wp-content/uploads

Disallow: /*?*

Disallow: /*?

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /langs/

Disallow: /images/

Sitemap: https://camerablog.jp/sitemap.xml

最後に【Submit】をクリックして完了。

設定方法は比較的カンタンなので、サイトを構築した時点で行っておくのが良いですね。また、ウェブマスターツールでエラーが出てないか随時チェックしておきましょう。